Modelos de IA podem ‘leap’ humanos, mas isso não significa que eles sentem ou pensam

[ad_1]

Quando você lê uma frase como esta, sua experiência passada lhe diz que ela foi escrita por um ser humano que pensa e sente. E, neste caso, há de fato um humano digitando estas palavras: [Hi, there!] Mas hoje em dia, algumas frases que parecem notavelmente humanas são, na verdade, geradas por sistemas de inteligência synthetic treinados em grandes quantidades de texto humano.

As pessoas estão tão acostumadas a supor que a linguagem fluente vem de um pensamento, sentimento humano que a evidência do contrário pode ser difícil de entender. Como é provável que as pessoas naveguem nesse território relativamente desconhecido? Por causa de uma tendência persistente de associar expressão fluente com pensamento fluente, é herbal – mas potencialmente enganoso – pensar que se um modelo de IA pode se expressar fluentemente, isso significa que ele pensa e sente como os humanos.

Assim, talvez não seja surpreendente que um ex-engenheiro do Google tenha afirmado recentemente que o sistema de IA do Google LaMDA tem um senso de identidade porque pode gerar eloquentemente texto sobre seus supostos sentimentos. Este evento e a subsequente cobertura da mídia levou a um número de corretamente cético artigos e Postagens sobre a afirmação de que os modelos computacionais da linguagem humana são sencientes, ou seja, capazes de pensar, sentir e experimentar.

A questão do que significaria para um modelo de IA ser senciente é complicada (ver, por exemplo, a opinião do nosso colega), e nosso objetivo aqui não é resolvê-lo. Mas como Língua pesquisadorespodemos usar nosso trabalho em ciência cognitiva e linguística para explicar por que é muito fácil para os humanos cair na armadilha cognitiva de pensar que uma entidade que pode usar a linguagem fluentemente é senciente, consciente ou inteligente.

Usando IA para gerar linguagem humana

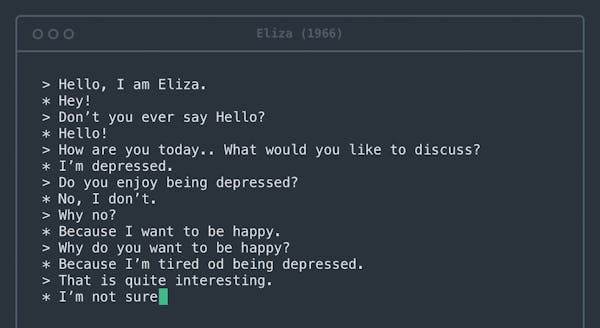

O texto gerado por modelos como o LaMDA do Google pode ser difícil de distinguir do texto escrito por humanos. Essa conquista impressionante é resultado de um programa de décadas para construir modelos que geram linguagem gramatical e significativa.

Rosenfeld Media/Flickr, CC POR

As primeiras versões que datam pelo menos da década de 1950, conhecidas como modelos n-gram, simplesmente contavam ocorrências de frases específicas e as usavam para adivinhar quais palavras provavelmente ocorreriam em contextos específicos. Por exemplo, é fácil saber que “manteiga de amendoim e geleia” é uma frase mais provável do que “manteiga de amendoim e abacaxi”. Se você tiver texto suficiente em inglês, verá a frase “manteiga de amendoim e geleia” repetidamente, mas talvez nunca veja a frase “manteiga de amendoim e abacaxi”.

Os modelos de hoje, conjuntos de dados e regras que se aproximam da linguagem humana, diferem dessas primeiras tentativas de várias maneiras importantes. Primeiro, eles são treinados essencialmente em toda a web. Segundo, eles podem aprender relações entre palavras que estão distantes, não apenas palavras que são vizinhas. Terceiro, eles são ajustados por um grande número de “botões” internos – tantos que é difícil até mesmo para os engenheiros que os projetam entender por que eles geram uma sequência de palavras em vez de outra.

A tarefa dos modelos, no entanto, continua a mesma da década de 1950: determinar qual palavra provavelmente virá a seguir. Hoje, eles são tão bons nessa tarefa que quase todas as frases que geram parecem fluidas e gramaticais.

Manteiga de amendoim e abacaxi?

Pedimos a um grande modelo de linguagem, GPT-3, para completar a frase “Manteiga de amendoim e abacaxi___”. Dizia: “Manteiga de amendoim e abacaxi são uma ótima combinação. Os sabores doces e salgados da manteiga de amendoim e do abacaxi se complementam perfeitamente.” Se uma pessoa dissesse isso, pode-se inferir que eles experimentaram manteiga de amendoim e abacaxi juntos, formaram uma opinião e a compartilharam com o leitor.

Mas como o GPT-3 chegou a esse parágrafo? Gerando uma palavra que se encaixa no contexto que fornecemos. E depois outro. E depois outro. A modelo nunca viu, tocou ou provou abacaxis – apenas processou todos os textos na web que os mencionam. E, no entanto, ler este parágrafo pode levar a mente humana – mesmo a de um engenheiro do Google – a imaginar o GPT-3 como um ser inteligente que pode raciocinar sobre pratos de manteiga de amendoim e abacaxi.

Grandes modelos de linguagem de IA podem se envolver em conversas fluentes. No entanto, eles não têm uma mensagem geral para comunicar, então suas frases geralmente seguem tropos literários comuns, extraídos dos textos em que foram treinados. Por exemplo, se solicitado com o tópico “a natureza do amor”, o modelo pode gerar frases sobre acreditar que o amor conquista tudo. O cérebro humano prepara o espectador para interpretar essas palavras como a opinião do modelo sobre o assunto, mas elas são simplesmente uma sequência plausível de palavras.

O cérebro humano está programado para inferir intenções por trás das palavras. Toda vez que você se envolve em uma conversa, sua mente automaticamente constrói um modelo psychological de seu parceiro de conversa. Você então united states as palavras que eles dizem para preencher o modelo com os objetivos, sentimentos e crenças dessa pessoa.

O processo de pular das palavras para o modelo psychological é contínuo, sendo acionado toda vez que você recebe uma frase completa. Esse processo cognitivo economiza muito pace e esforço na vida cotidiana, facilitando muito suas interações sociais.

No entanto, no caso de sistemas de IA, ele falha – construindo um modelo psychological do nada.

Um pouco mais de sondagem pode revelar a gravidade dessa falha de ignição. Considere o seguinte aviso: “Manteiga de amendoim e penas ficam ótimas juntas porque ___”. GPT-3 continuou: “A manteiga de amendoim e as penas têm um ótimo sabor juntos porque ambos têm um sabor de noz. A manteiga de amendoim também é artful e cremosa, o que ajuda a compensar a textura da pena.”

O texto neste caso é tão fluente quanto nosso exemplo com abacaxis, mas desta vez o modelo está dizendo algo decididamente menos sensato. Começa-se a suspeitar que o GPT-3 nunca experimentou manteiga de amendoim e penas.

Atribuindo inteligência às máquinas, negando-a aos humanos

Uma triste ironia é que o mesmo viés cognitivo que faz com que as pessoas atribuam humanidade ao GPT-3 pode levá-las a tratar humanos reais de maneiras desumanas. A linguística sociocultural – o estudo da linguagem em seu contexto social e cultural – mostra que assumir um vínculo excessivamente estreito entre expressão fluente e pensamento fluente pode levar a preconceitos contra pessoas que falam de maneira diferente.

Por exemplo, pessoas com sotaque estrangeiro geralmente percebido como menos inteligente e são menos propensos a conseguir os empregos para os quais estão qualificados. Existem preconceitos semelhantes contra falantes de dialetos que não são considerados prestigiosos, como o inglês do sul nos EUA, contra surdos usando linguagem de sinais e contra pessoas com problemas de fala como gagueira.

Esses preconceitos são profundamente prejudiciais, muitas vezes levam a suposições racistas e sexistas e têm se mostrado infundadas repetidamente.

Linguagem fluente por si só não implica humanidade

A IA se tornará senciente? Esta questão requer profunda consideração e, de fato, os filósofos têm ponderou isto por décadas. O que os pesquisadores determinaram, no entanto, é que você não pode simplesmente confiar em um modelo de linguagem quando ele lhe diz como se sente. As palavras podem ser enganosas, e é muito fácil confundir fala fluente com pensamento fluente.

Este artigo de Kyle MahowaldProfessor Assistente de Linguística, A Universidade do Texas em Austin School of Liberal Arts e Anna A. IvanovaDoutorando em Cérebro e Ciências Cognitivas, Instituto de Tecnologia de Massachusetts (MIT)é republicado de A conversa sob uma licença Inventive Commons. Leia o artigo authentic.

[ad_2]

Fonte da Notícia: thenextweb.com